INTRODUCTION

La plupart des religions embrassent et mettent en avant certaines idées sur le sens de la vie, qui justifient pour les croyants notre existence et celle de tous les autres organismes. C'est ce qui définit fondamentalement la foi religieuse : croire que la vie est orientée vers un but (divin). La science, en revanche, a toujours répondu par un "non" catégorique à cette question : « la vie a-t-elle un sens ? »

Mais depuis le début du 20ème siècle d’éminents savants, à l’instar d’Einstein, ont montré que même d'un point de vue scientifique, la vie sert à quelque chose et n'est pas dénuée de transcendance. Ils sont parvenus à cette conclusion en cherchant à résoudre un paradoxe qui intrigue depuis longtemps les passionnés de biologie et de physique: celui du « sens de la vie »……

LE DETERMINISME SCIENTIFIQUE

Le déterminisme est la théorie selon laquelle la succession des événements et des phénomènes est due au principe de causalité, ce lien pouvant parfois être décrit par une loi physico-mathématique qui fonde alors le caractère prédictif de ces derniers.

Le déterminisme permet la connaissance scientifique des phénomènes, qui peuvent être

reliés par des lois, c'est-à-dire par des relations de causalité constantes et universelles .

Sa principale application dans la science est : « Deux expériences avec exactement les mêmes

conditions initiales et les mêmes conditions limites doivent donner exactement les mêmes

résultats »

Laplace en 1814 énonce :

« Nous devons envisager l’état de l’Univers comme l’effet de son état antérieur et la cause de ce qui va suivre. Une intelligence qui pour un instant donné connaîtrait toutes les forces dont la nature est animée et la situation respective des êtres qui la composent, si d’ailleurs elle était assez vaste pour soumettre ces données à l’analyse, embrasserait dans la même formule le mouvement des plus grands corps de l’Univers et ceux du plus léger atome : rien ne serait incertain pour elle, l’avenir comme le passé serait présent à ses yeux. ».

Un tel déterminisme absolu est connu sous le nom de « déterminisme Laplacien ». Tout au

long du 19 ème siècle il fut considéré comme un élément fondamental des faits scientifiques

et la science fut admise comme quasi-infaillible, comme capable de répondre à toutes les

questions et en particulier aux questions philosophiques : Où sommes-nous ? d’où venons-

nous ? où allons-nous ? pourquoi sommes-nous sur Terre ?

Ce déterminisme absolu Laplacien peut-être synthétisé par ce qui a été appelé ‘le crédo

Du Scientisme :

1) La Science expliquera tout.

2) Les religions appartiennent au passé ( Auguste Comte).

3) Tout ce qui existe réellement peut être prouvé (je ne crois que ce que je vois)

4) Dieu est une invention de l’homme ( Freud, Feuerbach ).

5) L’Univers est infini et immuable, il a toujours existé, il existera toujours.

6) L’homme est un animal, c’est à dire de la matière organisée.

7) L’évolution n’est mue que par le hasard ( Darwin).

8) La Bible, les miracles sont des légendes ( Renan ).

9) La finalité n’est qu’une apparence, seul le déterminisme existe réellement.

En conclusion pour le déterminisme scientifique :

L’état initial d’un système détermine complètement son avenir.

Rien de neuf ne peut advenir qui ne soit déjà contenu dans les conditions initiales. Le

problème de la prévision semble dès lors résolu, du moins en théorie.

Bien entendu la philosophie idéologique correspondante au déterminisme Laplacien est le

matérialisme scientifique tandis que la croyance correspondante est l’athéisme

DU DETERMINISME AU CHAOS ET AU HASARD

Dans la seconde moitié du XIXe siècle, le déterminisme Laplacien est mis à

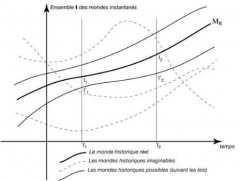

Dans la seconde moitié du XIXe siècle, le déterminisme Laplacien est mis à mal quand des mathématiciens entreprennent de calculer les trajectoires des astres. Henri Poincaré puis Jacques Hadamard découvrent alors que des systèmes pourtant simples, comme celui constitué de trois corps qui s’attirent par gravitation, donnent lieu à des trajectoires très compliquées et que, pour beaucoup de systèmes, la moindre variation des positions ou des vitesses initiales engendre des écarts de trajectoire considérables. Comme l’état initial n'est jamais connu avec une exactitude parfaite, on ne peut déterminer l’évolution d’un tel système au-delà d’un certain temps.

mal quand des mathématiciens entreprennent de calculer les trajectoires des astres. Henri Poincaré puis Jacques Hadamard découvrent alors que des systèmes pourtant simples, comme celui constitué de trois corps qui s’attirent par gravitation, donnent lieu à des trajectoires très compliquées et que, pour beaucoup de systèmes, la moindre variation des positions ou des vitesses initiales engendre des écarts de trajectoire considérables. Comme l’état initial n'est jamais connu avec une exactitude parfaite, on ne peut déterminer l’évolution d’un tel système au-delà d’un certain temps.

Ces travaux sont les prémices de la théorie du chaos , qui se développe à partir des années 1970 et étudie l’évolution de l’incertitude sur l’état initial.

À partir des années 1980, les astronomes montrent qu’il est impossible de connaître l’état du système solaire au-delà de quelque 100 millions d’années. Cet horizon dépassé, il faudrait tenir compte, dans les calculs, de la forme des astres, des effets des marées, et d’une multitude d’autres paramètres… Cette découverte ébranle beaucoup le déterminisme Laplacien.

Aujourd’hui nous savons que ce credo centenaire du scientisme a de moins en moins de fondement. Il a été attaqué à la fois de l’intérieur et de l’extérieur de la Science.

Les scientifiques se sont heurtés à plusieurs limites de la Science déterministe. Les plus célèbres sont :

Le principe d’incertitude( Heisenberg ).

Les mouvements chaotiques,

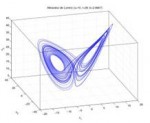

la sensibilité aux conditions initiales, l’effet papillon ( Henri Poincaré, Gaston Julia, Benoît Mandelbrot, Michel Hénon, E.N. Lorenz ).

Le temps de Liapounov, le temps de divergence( Ruelle, Takens, Bergé, Lighthill ).

Le paradoxe de la liberté.

la théorie de l’information.

Le principe d'incertitude d'Heisenberg (1927), implique l'impossibilité de connaître avec une

infinie précision la position et la vitesse d'une particule par rapport à un même temps donné,

contrairement aux données requises par le déterminisme de La place, on ne peut les

connaître qu'à l'aide d'une fonction de probabilité.

Etant contraire à l'hypothèse du déterminisme classique, le principe d'incertitude semble

impliquer que l‘univers obéit au libre jeu du hasard et de la nécessité.

Ce qui fit dire à Albert Einstein, qui adhéra longtemps au déterminisme: « Dieu ne joue pas aux

dés »

Ce à quoi Niels Bohr, plus indéterministe, répondit : « Einstein, cessez de dire à Dieu ce qu'il

Doit faire »

Et le reste de la communauté scientifique de se questionner : « Comment savoir à quoi Dieu

Joue ? »

HASARD ET CHAOS

SENSIBLITE AUX CONDITIONS INITIALES

Henri Poincaré l’a définie en 1908 :

« Une cause très petite, qui nous échappe, détermine un effet considérable que nous ne pouvons

pas ne pas voir, et alors nous disons que cet effet est dû au hasard. (...).

Il peut arriver que de petites différences dans les conditions initiales en engendrent de très

grandes dans les phénomènes finaux. Une petite erreur sur les premières produirait une erreur

énorme sur les derniers .La prédiction devient impossible et nous avons le phénomène fortuit. »

E.Lorentz 1963 : L’ effet papillon

« Cela implique, que deux états qui ne diffèrent que par d’infimes quantités peuvent évoluer

vers deux états totalement différents. Partant de là s’il y la moindre erreur dans l’observation

d’un état au temps présent, et de telles erreurs semblent inévitables dans n’importe quel

système réel, il se pourrait bien qu’il soit impossible de faire une prédiction valable de ce que

deviendra cet état dans un futur lointain. »

Et en une métaphore qui deviendra célèbre, Lorentz, exprime les difficultés et les limites de la

‘prédictabilité’ :

« Le battement d’ailes d’un papillon au Brésil peut-il déclencher une tornade au Texas ? »

A PROPOS DU CHAOS ET DU HASARD

Le hasard est l’inverse de la prédiction. Est hasardeux un système dont on ne peut prédire la réaction,

L’évolution.

Le chaos est l’inverse d’un système ordonné, l’inverse de l’ordre.

On lie souvent le chaos au hasard dans le sens ou le comportement d’un système est imprévisible, donc

aléatoire.

Ce que montrent les systèmes chaotiques c’est qu’une incertitude minime peut irrémédiablement conduire à

une totale impossibilité des prévisions. Cela a souvent été interprété comme un exemple de hasard, dans le

sens où le comportement du système est imprévisible, donc (c’est une définition du hasard), aléatoire.

Poincaré nous l’avons vu, a initié le phénomène de sensibilité aux conditions initiales : pour un système

chaotique, une très petite erreur sur la connaissance de l'état initial x0 dans l'espace des phases va se trouver

(presque toujours) rapidement amplifiée. Cette amplification des erreurs rend rapidement totalement

inopérant le pouvoir prédictif qui découle de l'unicité de la solution.

Plus récemment, des calculs numériques effectués par Sussman & Wisdom en 1992 ont montré que le Système solaire est chaotique, avec un horizon( temps de Lyapounov) de l'ordre de 200 millions d'années, apportant ainsi une limite et une incertitude qui , de ce fait, obère le caractère déterministe de la théorie Générale de la relativité d’Einstein.

ENTROPIE

Qu'est-ce que l'entropie?

Certains disent que l'entropie est une mesure du chaos (le désordre) et les autres qu'il s'agit d'une mesure

de la dispersion de l'énergie. Ce concept a été théorisé par Rudolf Clausius dans le milieu des années 1800,

formulé à partir de la première et la deuxième loi de la thermodynamique sous sa forme toujours valables.

La seconde loi de la thermodynamique dit essentiellement que l'énergie a toujours tendance à se disperser

Et quand cela arrive, l’entropie totale du système augmente dans l’environnement.

L’Entropie S est donnée par le rapport de l'énergie Q (quantité de chaleur en joule) et T (la température en

Kelvin, comme S = Q / T. S étant en J/K.

Ces principes sont les fondements de la thermodynamique. Pour qu'un système conserve sa structure

(premier principe de la thermodynamique), il doit dégrader le monde extérieur (second principe de la

thermodynamique). L'évolution conduit le monde d'un état homogène et ordonné vers un état déterminé, désordonné où toute la matière se décomposera et où seul le rayonnement subsistera, souvenir poignant

des systèmes organisés du passé ( mort thermique de notre système)

Le premier principe introduit le dogme de la conservation d'énergie et de l'équivalence entre travail (W)

et chaleur (Q) mesurés en Joules (J). L'énergie se conserve (mécanique, thermique, chimique,

électromagnétique), elle ne peut être ni créé, ni détruite mais elle se transforme. C'est à ce niveau que

"rien ne se perd, rien ne se crée, tout se transforme" (Lavoisier).

Le second principe énonce c'est que l'entropie n'est pas l'énergie. Ce qu'on perd ce n'est pas de l'énergie

mais seulement ses différences de répartition, la rigidité d'un ordre ( donc on acquiert du désordre), et la

chaleur produite.

Le second principe est le seul principe qui soit physique et dynamique, dit aussi principe d'évolution,

les autres principes étant purement formels.

On peut même considérer comme Einstein que c'est le principe le plus important de la physique:

L'interprétation dominante est celle d'une loi physique stricte, ce qui impliquerait qu'un gain d'ordre

d'un côté doit se payer par un désordre plus grand de l'autre, exprimant une totale confusion avec le

premier principe de conservation de l'énergie (et pas de l'entropie!)

L'interprétation orthodoxe, qui est celle de Boltzmann, est d'ordre statistique, ce qui est tout autre chose.

Il peut donc y avoir diminution locale de l'entropie (sinon rien ne pourrait jamais exister) même si ce n'est

Pas le plus probable et qu'il n'y aura jamais diffusion de chaleur du froid vers le chaud mais seulement du

chaud vers le froid. Il est certain que plus l'entropie est faible, plus il est probable qu'elle a des chances

d’augmenter mais plus elle est grande (proche de l'équilibre) et plus elle a des chances de diminuer.

(création d'ordre à partir du désordre).

Cette notion d’entropie négative est ce qu'on appelle l'auto-organisation. Il faut ajouter à cela la fonction de l'information qui permet à la vie de lutter contre l'entropie par une création d'ordre à partir de l'ordre, réussissant à répandre partout et rendre probable le plus improbable : la vie elle-même. Ce qu'il faut souligner, c’est la finalité pratique du concept d'entropie et son horizon humain.

L'auto-organisation est donc un phénomène de mise en ordre croissant, et allant en sens inverse de l'augmentation de l'entropie; aux prix bien entendu d'une dissipation d'énergie qui servira à maintenir cette structure.

Pour expliquer l'entropie il faut donc faire intervenir une perte d'information à chaque collision ou interaction, un oubli des conditions initiales (ou pour suivre le s travaux de Prigogine de 1962, le fait qu'il y a des composantes négligeables, au regard des composantes principales, dont l'influence est donc perdue).

Ce fameux deuxième principe de la thermodynamiqueest à la fois une loi implacable (irréversible) qu'on retrouve partout (tout système isolé perd de l'énergie utilisable, réduit son différentiel d'énergie), mais c'est aussi bien une loi statistique qui se laisse contredire assez facilement par une intervention extérieure, notamment par l'information et les organismes biologiques qui savent en tirer parti.

La microphysique(quantique) est discontinue, probabiliste, linéaire, réversible, alors que la physique macroscopique qui en découle est continue, déterministe, non linéaire, irréversible.

Nous touchons là le concept selon lequel la physique (Brillouin) en vient à s’exprimer en termes d’information. L’information devient un terme physique au moment où toute la physique se révèle affaire d’information.

On ne peut nier qu'il y a bien égalité stricte, à l'inversion du signe près, entre l'entropie et la quantité d'information. L'entropie peut effectivement se définir comme l'information perdue, le désordre, la m multiplication des configurations possibles, des irrégularités, la perte de forces structurantes à longue portée et le manque d'information qui en résulte. Quand l'entropie augmente, notre information diminue.

INFORMATION

Concept de l’information

Le concept d'information a des implications fondamentales en physique, biologie, économie, politique, philosophie, robotique, etc. L'information est un concept qui ne désigne pas une qualité simple mais une structure composée, complexe et de nature biologique, qui se distingue fondamentalement du signal physique et de l'énergie par un ensemble de propriétés :

- son improbabilité et sa discontinuité (saillance, différence, nouveauté)

- la réduction de l'incertitude (sens, prévision, représentation, visibilité de l'invisible),

- son imperfection qui exige une correction permanente (parer à l'imprévu, ajustement)

- un récepteur pour lequel elle fait sens (réaction conditionnelle, mémoire, contexte, dialogue)

- son caractère de signe d'autre chose (codage numérique, prose du monde, transcendance, existence) et donc reproductible à l'opposé de la matière ou de l'énergie

- un effet disproportionné à l'énergie en jeu ou aux rapports de force (non calculable)

- une reproduction et une durée qui échappent à l'entropie (au temps physique) grâce aux corrections d'erreurs et régulations (évolution, complexification, optimisation)

La Théorie de l’information (Shannon 1948)

C’est une théorie probabiliste permettant de quantifier le contenu moyen en information d'un ensemble de messages, dont le codage informatique satisfait une distribution statistique précise. Ce domaine trouve son origine scientifique avec la publication de Shannon : Mathematical Theory of Communications publié en 1948. Les branches de cette théorie ont permis l’éclosion du codage de l'information, de la mesure quantitative de redondance d'un texte, de la compression de données, et de la cryptographie.

l'information présente un caractère essentiellement aléatoire. Un événement aléatoire est par définition incertain. Cette incertitude est prise comme mesure de l'information. Une information sera donc uniquement définie par sa probabilité (I = - log p). Donc l'information est la mesure de l'incertitude calculée à partir de la probabilité de l'événement. Shannon a donc confondu la notion d'information et de mesure d'incertitude. Il faut remarquer que dans cette définition l'information est bien synonyme de mesure d'incertitude. Dans cet ordre d'idée, plus une information est incertaine, plus elle est intéressante, et un événement certain ne contient aucune information. En théorie de l‘ information de Shannon, il s'agit donc de raisonner en probabilité et non en logique pure.

La conscience elle-même peut être définie comme manque d'information, exploration des mystères du monde (étonnement, interrogation et vérification, "Penser c'est perdre le fil" dit Valéry

l'information présente un caractère essentiellement aléatoire. Un événement aléatoire est par définition incertain. Cette incertitude est prise comme mesure de l'information. Une information sera donc uniquement définie par sa probabilité (I = - log p). Donc l'information est la mesure de l'incertitude calculée à partir de la probabilité de l'événement. Shannon a donc confondu la notion d'information et de mesure d'incertitude. Il faut remarquer que dans cette définition l'information est bien synonyme de mesure d'incertitude. Dans cet ordre d'idée, plus une information est incertaine, plus elle est intéressante, et un événement certain ne contient aucune information. En théorie de l‘ information de Shannon, il s'agit donc de raisonner en probabilité et non en logique pure.

LE PARADOXE DE LA LIBERTE

Dès que nous pensons à la science, à l’expérience scientifique, surgit en nous l’idée, le spectre

d’un déterminisme et donc d’une absence de liberté dans le monde, y compris pour les êtres

humains qui en font partie.

Faut-il croire à la liberté?

La liberté ne se voit pas , elle se traduit par une absence, au mieux c’est une croyance fondée ou

Infondée, ou pire, une illusion.

L’ambivalence et la duplicité de l’être humain appartient au déterminisme, il est un phénomène

parmi les phénomènes. Plus la connaissance scientifique s’étend, moins la liberté apparait, au

contraire , c’est le déterminisme qui domine. Dans ce contexte il suffit de connaitre la nature pour

voir que tout est nécessaire.

Les lois morales font échapper l’individu à cet état, elles permettent de déduire cette sublime

notion que nous découvrons en nous par intuition.

En conséquence , la liberté n’est pas dépouillée de contrainte. La liberté est le pouvoir de se

donner à soi-même des lois, qui sont les lois universelles, celles de la raison.

C’est lorsque la raison me donne des lois que cela me rend libre car je m’éloigne de mes passion

(passivité: c’est la nature qui agit en moi, mes instincts, je ne suis plus libre)

Si la liberté existe, on ne peut la connaitre: il y aurait en nous une liberté absolue que l’on appelle

libre arbitre… Est-ce une croyance ? Spinoza l’a appelée ‘ liberté de l’indifférence’ et l’a niée.

Mais nier le libre arbitre n’est pas nier la liberté, c’est au contraire la condition même de la

liberté.

Le seul obstacle à la liberté, c’est la croyance à la liberté……Disait Spinoza….

Si le déterminisme du monde cesse ainsi d’apparaître absolu, s’il y a des espaces de liberté

pour la nature, ne peut-on pas prétendre aussi à une place pour la liberté humaine ?

LA FINALITE

Einstein a laissé deux théories géniales : la relativité générale et la mécanique quantique.Il a légué au monde deux visions qui sont incompatibles bien qu'elles soient exactes.

Jusqu'à la fin de sa vie, Einstein a tenté de résoudre l'incompatibilité entre les deux théories fondamentales de la physique.

Points forts de la relativité générale :

Elle englobe la théorie de la gravitation de Newton qui n'est plus qu'une approximation. Elle prédit avec précision la déviation de la lumière, l'évolution de l'univers et la position des satellites autour de la Terre. Elle n'a jamais été prise en faute malgré 90 ans de confrontations avec les observations.

Points forts de la mécanique quantique :

Elle est capable d'expliquer avec une extraordinaire précision toutes les étrangetés observées dans le monde microscopique. Elle est à la base de la plupart des technologies du XXe siècle, comme les lasers, les ordinateurs, les supraconducteurs et l'énergie nucléaire.

Alors que les deux théories affichent de vrais succès, elles divergent sur tout !

Quatre grands points de discorde :

1). Le hasard, inexistant dans la relativité qui est déterministe, est prépondérant dans le monde quantique qui est probabiliste.

2). La structure de l'espace-temps, dynamique et déformée selon la répartition de matière qu'il contient (selon la relativité), est statique et plate dans le monde quantique qui ne dépend pas de la matière qu'il contient.

3). La représentation des forces, qui sont induites par la courbure de l'espace-temps (selon la relativité), n'est que des échanges de particules selon la théorie quantique.

4). L'énergie du vide, nulle selon la relativité, est colossale (voire infinie) selon la théorie quantique.

Comment résoudre la contradiction entre ce qui semble vrai pour la vie - elle organise la matière en créatures et en structures de plus en plus complexes - et l'idée que le désordre est voué à augmenter et l'ordre à disparaître ? Autre question tout aussi importante : quel est le sens de la vie perçu par la science dans la résolution de ce paradoxe ?

En fait, le deuxième principe de thermodynamique gouverne, et l'existence de la vie contribue à l'augmentation de l'entropie. Autrement dit, la vie encourage le désordre. On pourrait alors penser que l'aboutissement logique de l'évolution et de la vie intelligente est une explosion nucléaire et l'anéantissement de la Terre. En fait, la tendance actuelle est de distinguer matière et énergie, et concevoir que la matière structurée distribue l'énergie plus rapidement que la matière répartie au hasard.

Plus la structure est complexe plus la distribution de l'énergie est efficace. De ce point de vue, les populations sont supérieures aux individus isolés, les écosystèmes encore plus, et les structures les plus efficaces - à ce jour - sont les sociétés humaines de haute technologie.

Ainsi, le deuxième principe de thermodynamique n'irait pas à l'encontre de l'existence de la vie ; il en serait la cause. Il entraînerait l'évolution vers une complexité croissante, vers des sociétés et des technologies plus perfectionnées, dans le seul but de distribuer de l'énergie.

La vie a donc enfin un sens aux yeux de la science, une réflexion spirituelle et l’hypothèse d’une transcendance à partir d’une réflexion moderne sur le deuxième principe de thermodynamique peut être engagé par chacun de nous en toute ‘liberté’……

CONCLUSION

Le moins que l’on puisse dire, c’est que le terme entropie n’inspire pas de bons souvenirs chez ceux qui l’ont abordée en milieu scolaire. C’est probablement la grandeur courante considérée comme la plus absconse d’une discipline thermodynamique ; discipline que le physicien allemand Arnold Sommerfeld décrit: de la façon suivante :

La thermodynamique est un truc marrant :

- La première fois que vous l’abordez, vous ne comprenez rien.

- Le seconde fois que vous l’abordez, vous pensez tout comprendre, sauf un ou deux points.

- La troisième fois que vous l’abordez, vous savez que non, vous n’avez rien compris, mais ce coup-ci vous avez l’habitude et vous n’en avez plus rien à fiche.

En fait, c’est la manière d’aborder cette discipline, la manière statistique, qui complique considérablement les choses :

On vous parle de température, de chaleur, d’énergie (jusque là c’est facile), puis de ce truc (l’entropie) qui caractérise un système, mais qui ne décroit jamais. Qui a rapport avec le désordre. Et on vous fait faire des tas ce calculs très compliqués autour de ça……

OH MON DIEU !!!